株式会社サムライズム – Azul Systems社の製品を取扱開始

株式会社サムライズム(本社:東京都、代表取締役:山本 裕介)は、JavaプラットフォームのリーディングカンパニーであるAzul Systems社の製品の取扱を開始したことをお知らせいたします。

Azul Systems

https://www.azul.com/ja/

株式会社サムライズム

https://samuraismcom.samuraism.com/

背景

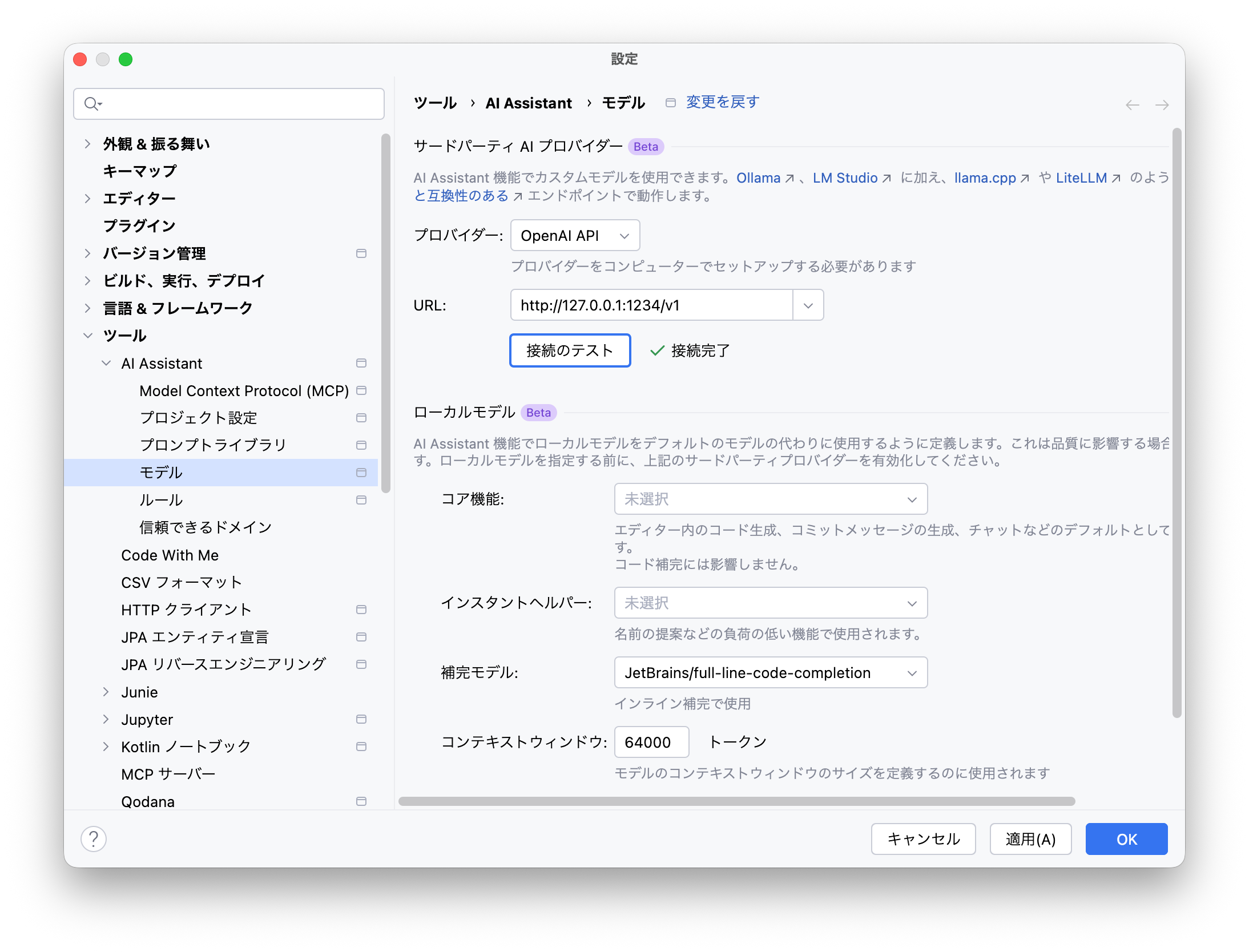

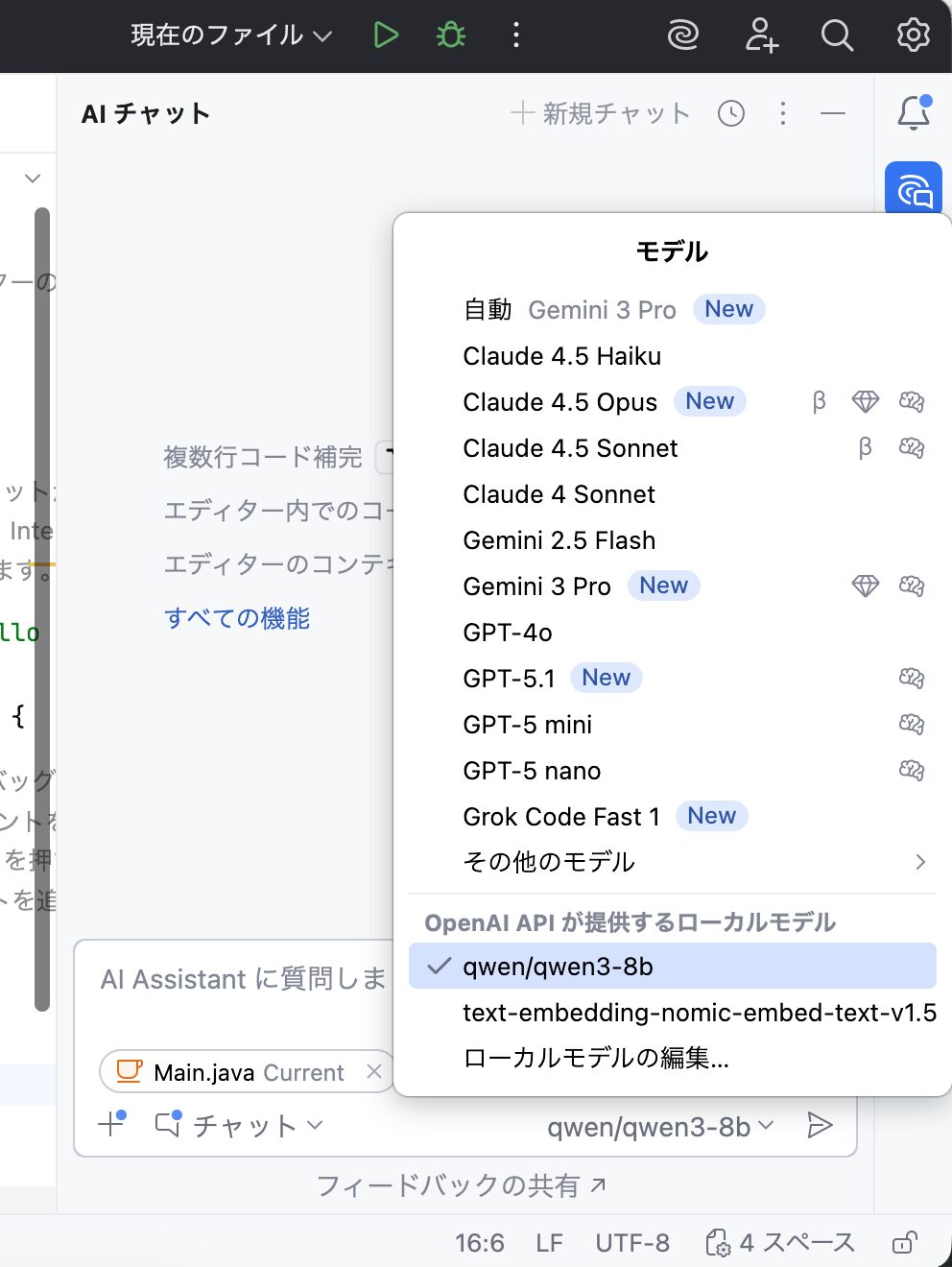

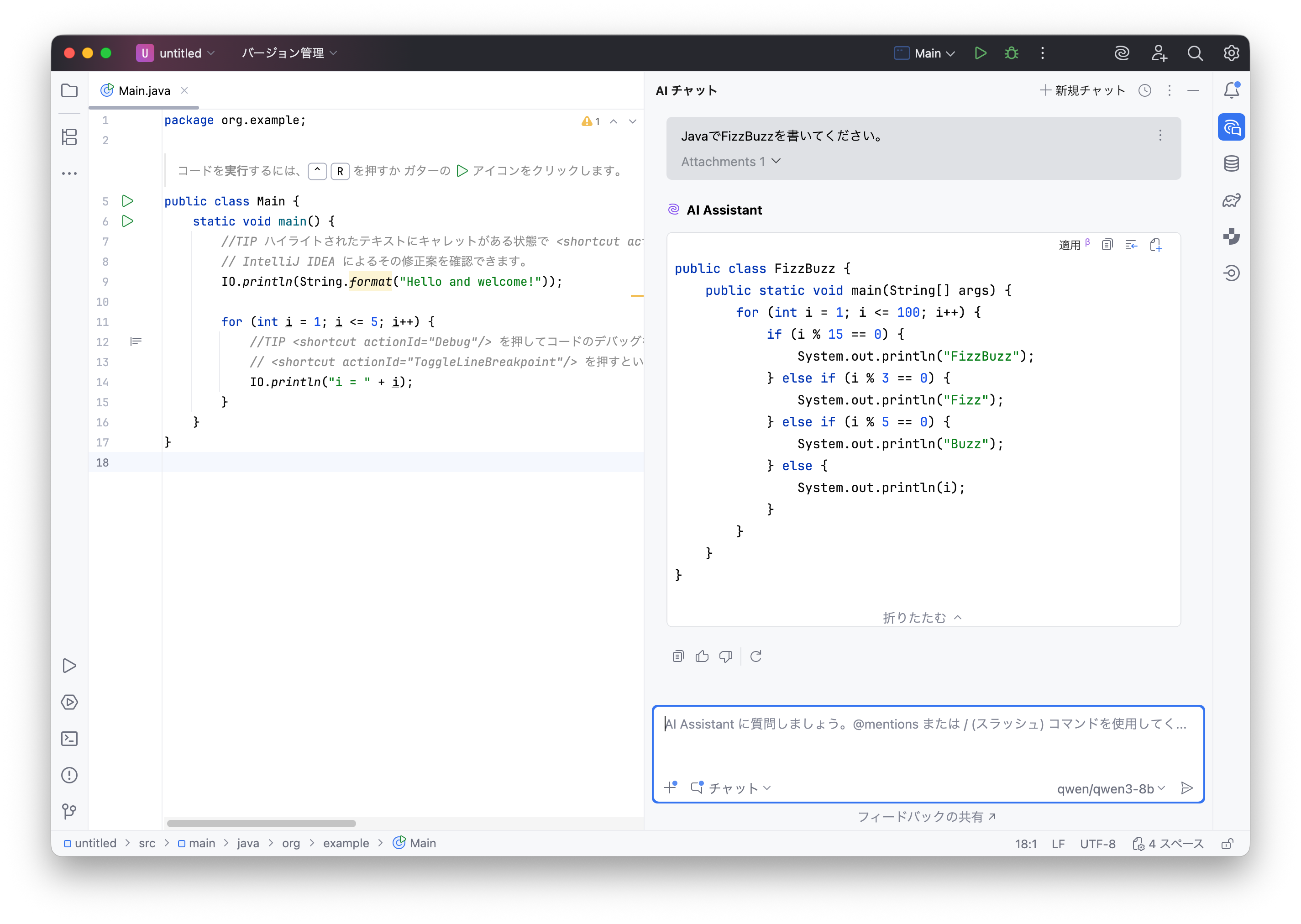

クラウドコンピューティングや仮想化技術、AIの普及により、システムの開発・展開は大きく効率化しました。一方で、運用環境の高度化・複雑化に伴い、セキュリティリスクの増大や運用管理コストの上昇といった課題が顕在化しています。

Azul Systems社の製品を導入することで、Javaアプリケーションを変更することなく長期的なJVMサポートを受けられるほか、パフォーマンス向上によるコンテナ稼働数の最適化、さらに既知の脆弱性の実際の悪用可能性を可視化することが可能になります。

これにより、システム全体の運用コストを抑制するとともに、サイバー攻撃に対する防御力の強化に貢献します。

Azul Systems社について

Azul Systems社は2002年に設立されたJavaプラットフォームのリーディングカンパニーで、米国カリフォルニア州サニーベールに本社を構えています。Fortune 500企業の25%以上を含む世界中の企業に採用されており、高性能かつ高信頼性のJavaランタイムおよびプラットフォームソリューションを提供しています。

Webサイト: https://www.azul.com/ja/

住所:

385 Moffett Park Dr, Suite 115

Sunnyvale, CA 94089

株式会社サムライズムについて

株式会社サムライズムは、オープンソース、Web、API技術を中核としたソフトウェアソリューションプロバイダです。

国内トップクラスのソフトウェア導入支援実績とAPI活用ノウハウを活かし、企業のDX推進を支援する製品およびサービスを提供しています。

株式会社サムライズム

英文表記: Samuraism

代表者: 山本 裕介

設立: 2013年3月

Webサイト: https://samuraismcom.samuraism.com/

Twitter: @samuraism

本リリースに関するお問い合わせ

株式会社サムライズム 代表 山本 裕介

電話: 03-4405-5117

メール: